티스토리 뷰

LLM 이란

대규모 '언어 모델'으로

컴퓨터에게 언어를 가르치는 방법 이다.

여러가지 언어 모델이 존재

1. 통계적 언어 모델 - 초창기 언어 모델로 통계를 기반하여 학습

n-gram 형태

The cat sat on the mat

1-gram

The / cat / sat / on / the / mat

2-gram

The cat / cat sat / sat on ...

3-gram

The cat sat / cat sat on ....

-> 통계적 패턴 학습을 통한 예측

단점: 문맥 이해도가 떨어짐

2. 신경망 언어 모델

인간의 뉴런 세포가 서로 연결되어 정보 처리하는 방식을 본 따 만듦

입력층 -> 은닉층(데이터 처리, 패턴 학습) -> 출력층

대표적인 신경망 언어 모델

1) RNN(Recurrent Neural Networks)

- 시퀀스 데이터 처리용으로 주식 가격, 날씨 변화 등 시간에 따른 분석으로 미래 예측 가능

단점: 긴 시퀀스를 처리하기에 데이터 저장 공간이 적음

2) LSTM(Long Short-Term Memory Networks)

- RNN에 메모리(장기 기억용)를 추가함. 긴 시퀀스도 처리 가능

3. 트랜스포머 (최신 언어 모델)

- 구글 브레인에서 발표한 언어 학습 모델 아키텍쳐

- 문장과 단락 전체를 처리할 수 있음

1) BERT (Bidirectional Encoder Representations from Transformers)

- 주어진 문장을 양방향(Bidirectional)으로 학습하여 문맥을 파악하는 언어 모델

2) GPT (Generative Pretrained Transformer)

- 오픈 AI에 의해 개발된 인공지능 언어 모델

- 다른 언어 모델에 비해 자연스로운 텍스트 생성, 수준 높은 대화

언어 모델에 대해 알아봤고, LLM에 대해 알아보겠습니다.

LLM (Large Language Model) - GPT-3.5, GPT-4, 구글의 버트, 제미나이

- 대규모 데이터로 학습됐음

- GPT-3

- 45TB 데이터 학습

- 텍스트 페이지 수십억장

- 모델의 크기도 큼 (파라미터의 수)

- 파라미터란 데이터 연결 방법

- GPT-3 1750억개

- GPT-2 15억개

LLM의 특징

1. 데이터 학습 - 인터넷 텍스트, 책, 논문, 기사 등 방대한 데이터

2. 데이터 이해 및 생성 - 언어를 이해하고 생성하는 과정, 질문 답변, 글 작성, 대화 생성

3. 특정 작업을 위한 추가 학습 (파인튜닝)

4. GPU, TPU(구글 하드웨어)가 필요

LLM 종류

1. GPT-4

- 멀티 모달 지원

- 사진+질문으로 답변 생성

- 텍스트, 이미지, 오디오, 비디오 처리 가능

2. 팜2 (PaLM2)

- Google I/O 20023에서 공개

- GPT-4 보다는 ..

3. 라마2 (LLaMA2)

- 메타에서 개발

- 오픈소스로 제공

- 집단지성을 통해 안전과 보안을 향상시킬 수 있다고..

LLM vs GAI

- LLM은 위 예시..

- 텍스트 위주 학습

- 텍스트 기반 질문 답변

- 질문을 'prompt' 라고 함

- 질문에 대한 답변은 'completion'

GAI (Generative AI)

- 새로운 컨텐츠를 생성하는 목적

- 텍스트, 이미지, 음악, 비디오 등

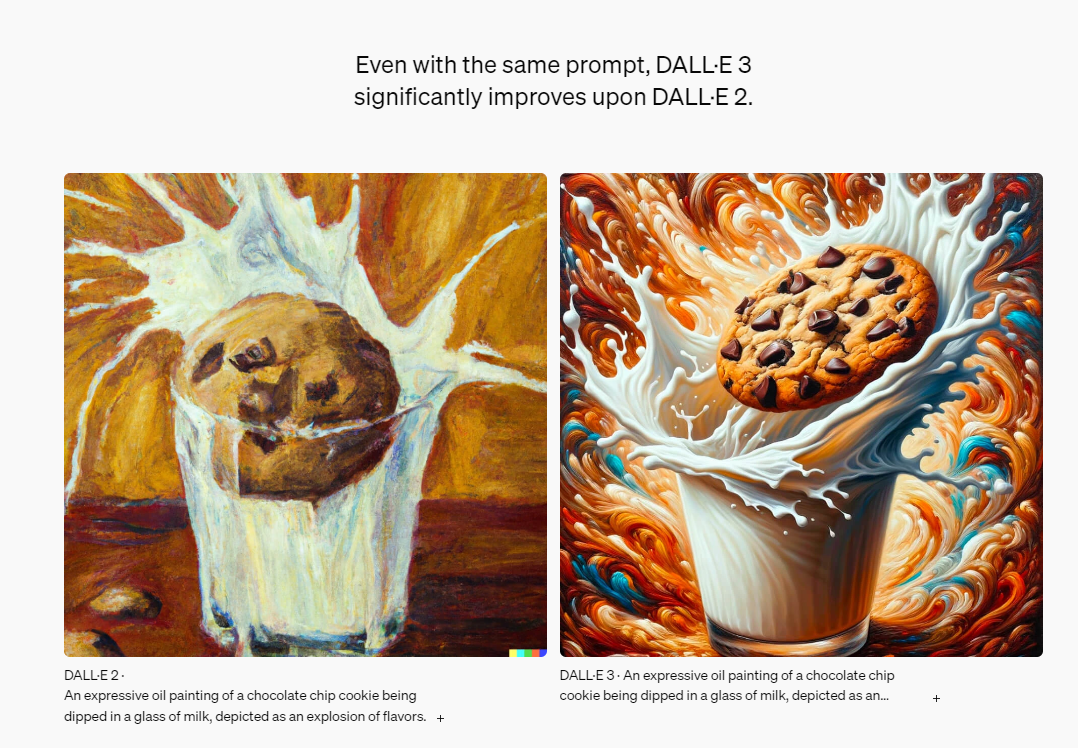

- DALL E2 로 그림 생성 (DALL E3까지나온듯)

LLM 생성 과정

1. 데이터 수집 및 준비

- 1) 학습할 데이터 식별 및 데이터 수집

- 2) 학습할 데이터 품질 향상 - 중복 제거, 무의미 데이터(오타, 관련없는 데이터) 제거

- 3) data를 LLM 학습용 데이터로 변환 - (문장을 작은 단위로 토큰화, 정규화)

- 4) 데이터 형식변경 - YYYY-MM-DD

2. 모델 설계

- 1) 큰 신경망을 구축하는 것을 의미

- 2) 주로 트랜스포머라는 언어 모델로 설계

- 3) 계층수, 학습률, 배치크기등을 조절하는 '하이퍼파라미터'를 조절하여 어떻게 학습할지 결정

3. 모델 학습

- 1) 설정한 하이퍼파라미터와 모델 아키텍쳐(트랜스포머)로 데이터 학습, 패턴 학습

- 2) 내부적으로 모델링 하여 텍스트를 생성하여 번역, 등 학습하는 과정

- 3) 모델링 - 데이터의 특징, 관계 등을 학습하고 수학적 구조로 표현하는 과정

- 4) e.g. 개인지 고양이인지 구분하는 패턴이 '모델링'

4. 평가 및 검증

5. 배포 및 유지 보수

추가적으로 고려사항

LLM 배포 시 윤리적 법적 사회적 책임을 고려해야함.

지속적 감시 방법

- 1) AI가 스스로 악의적 문구를 탐지

- 2) 사람이 'completion'을 점검

- Total

- Today

- Yesterday

- swift 네트워크 모듈화

- rag 기반 llm 챗봇

- 엔디소프트 레이세이

- swift 엑셀 가져오기

- swift urlcomponent encode

- focus timer 어플

- swift 엑셀 읽기

- swift get excel

- chatgpt rag llm

- swift urlsession network module

- swift queryitem encode

- swift urlsession 공통화

- swift network module

- swift network 공통화

- 공부 타이머 어플

- 레디세이

- swift urlsession module

- readysay

- swift filemanager excel

- rag 기반 llm

- swift urlsession refactoring

- swift excel read

- llm pdf rag

- llm csv

- swift network refactoring

- 레디세이 어플

- rag llm pdf

- swift 자간

- filemanager excel read

- swift filemanager get excel

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |